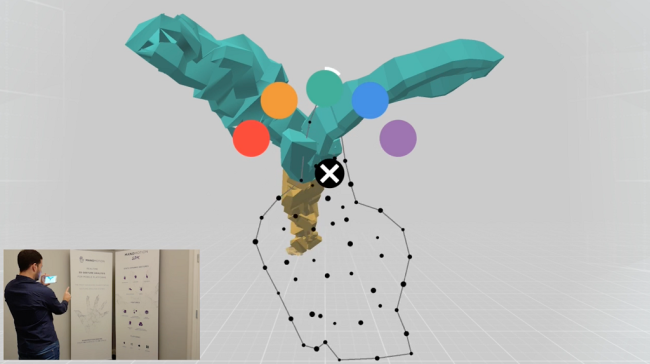

スマホVRにジェスチャー操作を追加するSDKが開発され、デベロッパーに向けて公開される。

開発はスウェーデンと米国に拠点を置くソフトウェア開発会社、ManoMotionによるもの。

SDKについて

iOS、Android対応

本SDKはIOS、Androidの両方に対応しており、開発者の制作するアプリであればどんなものにもジェスチャー操作を組み込むことが出来、Unityのゲームエンジンのプラグインとして機能する。

あらゆる種類のジェスチャー操作に対応

キットはフリーミアム(あらかじめフリーで公開され、カスタマーのニーズに応じて課金して機能を追加するシステム)でリリースされ、カスタマーのニーズに応じたサービス提供を目指している。

これによってユーザーはスマホVR/AR空間の中で自由にオブジェクトを配置したり、動かすことができるようになり、様々なジェスチャー、例えばVR/AR空間内でのスワイプ、クリック操作などがメニューやディスプレイから追加することが出来る一方で、ポインティングやプッシュ、ピンチやスワイプなどの操作もVR空間で出来るようになる。

27DoFによる正確なトラッキング

ジェスチャーのトラッキングはスマートフォンの2Dカメラで、もしくはGear VR用スマホであればデプスカメラで行うことが出来、手の動きを27の自由度(DOF)によってリアルタイムで把握することが可能で、これによって正確で遅延のないジェスチャー認識が可能になり、この技術はManoMotionが開発した3Dリアルタイムジェスチャー認識技術によるものである。

スワイプやクリック、タップしたりオブジェクトを掴んだり離したり、といった様々なジェスチャーを細部に到るまでトラッキングすることが可能であり、かつCPUやメモリー、バッテリー消費量が最小限で済むような設計がなされている。

シンプルで確実なジェスチャー認識

このSDKは、アプリやゲームの操作のために必要なすべてのジェスチャーを認識することが可能だが、それを認識する際、カメラで読み込んだ手の形を2つのカテゴリーーStatic Gesture(静的ジェスチャー)とDynamic Gesture(動的ジェスチャー)ーに分けることによって、正確なジェスチャー認識を実現する。

Static Gesture(静的ジェスチャー)

静的ジェスチャーとは静止状態の手の形を1つのフレームとして認識するジェスチャーであり、SDKではこれを大きく4つに分類する。

![]()

1:Backー手を閉じて甲をカメラに向けた状態

2:Palm-手のひらをカメラに向けて指を開いた状態

![]()

3:Pinch:親指と人差し指で小さいものを掴むような手の形

![]()

4:Pointer:グー手に人差し指を伸ばして物を指す手の形

Dynamic Gesture(動的ジェスチャー)

動的ジェスチャーとは手の動きを複数のフレームによって認識するジェスチャーであり、物を掴んだり、クリックしたり、物を動かしたり左右にスワイプしたりと動きを伴う動作で使用する。

![]()

1:Open Hand-VR/AR空間で物を掴む動作は、手を広げる→手を握る、という2つの静的ジェスチャーとその中間の動作を複数のフレームで認識することによって成り立つ。

2:Open Pinch-VR/ARでオブジェクトを選択したりメニューを起動する際に使うクリック動作は、静的ジェスチャーのPinchから、それの親指と人差指をくっつけるまでの動作をフレーム認識することによって成り立つ。

![]()

3:Pointer-プッシュやタップといった操作は、静的ジェスチャーのPointerの人差し指を上下に動かす動作を認識することによって成り立つ。

![]()

4:Swipe Right-左右のスワイプは、静的ジェスチャーのBackを左右に動かす動作を認識することによって成り立つ。

VR/ARアプリでのジェスチャー操作はとても重要で、アプリ内でインタラクションをするコンテンツは今後増えてくると予想されるが、現在市販されているデバイスでジェスチャー認識が出来るデバイスというとHoloLensぐらいしかなく、VRHMDのコントローラー操作はトリガーとボタンの2つに限られるので、VRでジェスチャー操作が可能になることの意義は大きい。

ManoMotionの創業者兼CEOであるDaniel Carlmanは、今回のSDK公開に併せて以下のように語っている。

いずれはコントローラー不要で、ほとんどの操作がジェスチャーによって出来る日が来るかもしれない、今後も注目を続けたい。

参照元:VRFocus

参照元:ManoMotion

Copyright ©2017 VR Inside All Rights Reserved.