新モデルはオープンアクセスLLMのHugging Faceリーダーボードで1位に

1800億のパラメーターを持つこのモデルは、MetaのLLaMA 2の4倍の計算リソースを備え、3.5兆のトークンでのトレーニング済み

Falcon 180Bは研究者と商用ユーザー向けにオープンアクセスを提供

アラブ首長国連邦・アブダビ--(BUSINESS WIRE)--(ビジネスワイヤ) --アラブ首長国連邦(UAE)の技術イノベーション研究所(TII)は、主力の大規模言語モデル(LLM)のハイスペックモデルであるFalcon 180Bを導入し、生成AIの限界をさらに押し広げます。この画期的とも言えるリリースにより、AIにおけるUAEの優位性が強化されるとともに、Falcon 180Bが、研究および商業目的のオープンアクセスモデルとして提供されます。

2023年5月にLLMのHugging Faceリーダーボードのトップに上り詰めたオープンソースAIモデルであるFalcon 40Bが大きな成功を収めたのに続き、アブダビ先端技術研究評議会(ATRC)が推進する応用研究の柱であるTIIは、生成AIに関して引き続き世界をリードします。Falcon 40Bは、研究者と商用ユーザーの両方にとってオープンソースモデル初のインスタンスの1つであり、この分野におけるパイオニア的な存在であると評価されました。

先端技術研究評議会の事務総長であるファイサル・アル・バンナイ閣下は、FalconがAIに及ぼすプラスの影響を強調しつつ、「私たちは、私たちのプライバシーとAIが人類に及ぼす潜在的な影響は、選ばれた少数の人によってコントロールされるべきではないとの認識から、高度なAIへのアクセスを民主化することに取り組んでいます。私たちがすべての答えを提供できるわけではないかもしれませんが、オープンソース コミュニティに協力・貢献し、AIのメリットをすべての人が共有できるようにするという私たちの決意は揺るぎません」と述べています。

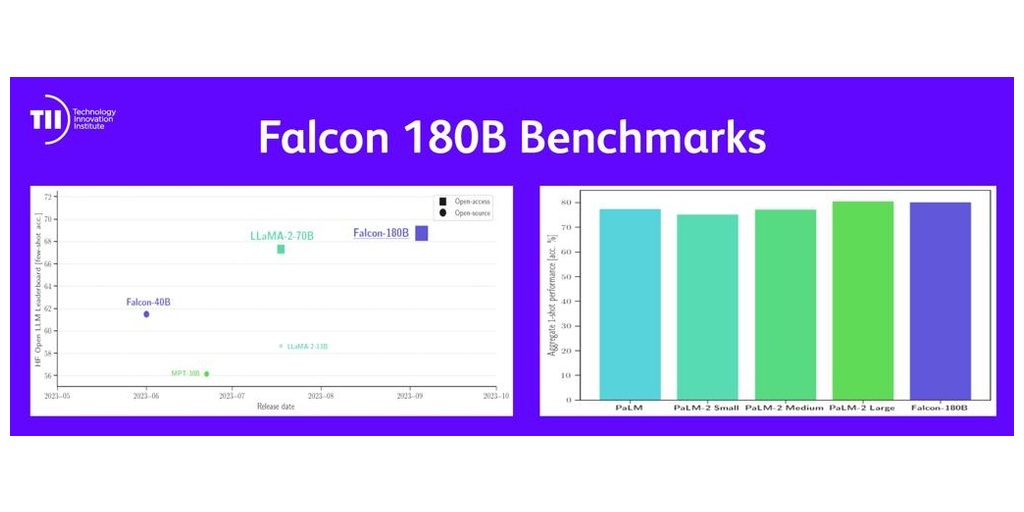

Falcon 180Bは、1800億という驚異的なパラメーターと3.5兆のトークンでトレーニングされたことで、事前トレーニングされたLLMとしてHugging Faceリーダーボードのトップに躍り出ました。推論、コーディング、熟練度、知識テストなどのさまざまなベンチマークで、MetaのLLaMA 2などの主要な競合他社をも上回っています。

最高のクローズドソースLLMとの比較では、Falcon 180BはOpenAIの最新GPT 4のすぐ後ろに位置し、モデルが半分のサイズであるにもかかわらず、Bardを強化するモデルであるGoogleのPaLM 2 Largeのパフォーマンスと同レベルとなっています。このモデルのライセンス フレームワークは、Apache 2.0に基づく「Falcon 180B TII ライセンス」が基本となっています。

TIIのAIクロスセンター・ユニットのエグゼクティブ・ディレクター兼主任研究員代理であるエブテサム・アルマズロウエイ博士は、「ファルコン 180Bの導入は、AIの最前線を行くTIIのコミットメントを体現するもので、その無限の可能性を世界の人々と共有できるのを楽しみにしています。Falcon 180Bは、生成AIの新時代の到来を告げるものであり、科学の進歩がオープンアクセスを通じて利用可能となることで、明日のイノベーションを推進します。科学と技術のフロンティアを掘り下げるとともに、私たちのビジョンはイノベーションをはるかに超えて広がります。これは、深いつながりを推進し、協力によるブレークスルーを通じて世界的な課題への取り組みを可能にします」と述べています。

1200万人を超える開発者がFalconの初回リリースを採用・展開しており、この主要なアップグレードは、チャットボットからコード生成などに至るまで、さまざまな分野のプレミア モデルとなるとみられています。

Falcon 180Bは、英語、ドイツ語、スペイン語、フランス語との互換性がありますが、イタリア語、ポルトガル語、ポーランド語、オランダ語、ルーマニア語、チェコ語、スウェーデン語での機能は限定されています。

詳細は、FalconLLM.tii.aeでご覧ください。

出典:AETOSWire

本記者発表文の公式バージョンはオリジナル言語版です。翻訳言語版は、読者の便宜を図る目的で提供されたものであり、法的効力を持ちません。翻訳言語版を資料としてご利用になる際には、法的効力を有する唯一のバージョンであるオリジナル言語版と照らし合わせて頂くようお願い致します。

Contacts

Jennifer Dewan, Senior Director of Communications

jennifer.dewan@tii.ae.